En digitalDot hemos querido tratar este punto del posicionamiento y factor de seguridad porque recientemente todas las auditorías de SEO que nos han llegado, tenían el fichero robots.txt, sin atribuir.

En nuestra agencia siempre intervenían, por un lado, nuestro consultor SEO que detectaba el fallo mediante una auditoría del tipo de contenido de la web y nuestro técnico de sistemas que lo implementaba y aportaba, de paso, las mejoras en seguridad web.

Por ello nos hemos embarcado en explicar la potencia que nos puede brindar el robots.txt en, por ejemplo, un WordPress.

Contenido

Es un fichero txt que informa a arañas y buscadores si está permitida la rastreabilidad de una web, sobre que contenido, que velocidad y en que URLs puede navegar.

Este simple ficherito en txt tiene bastante potencia para nuestra página web.

Si nos sirve para restringir la parte de seguridad la tenemos clara, podemos bloquear aquellos robots que hagan uso de este fichero evitando rastreos o consumo de tráfico innecesarios para nuestro servidor Web y especificar el factor de la velocidad que queremos otorgarle.

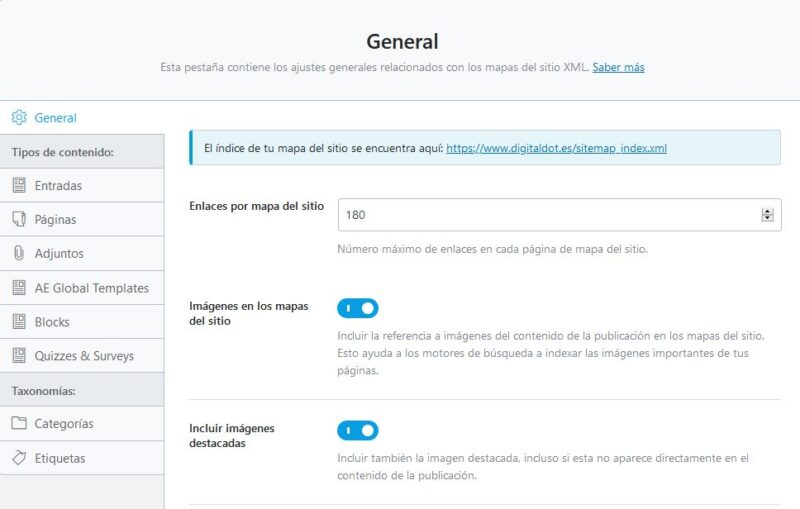

Un punto importante para cualquier web es el sitemap, uno o varios ficheros que muestran la estructura jerárquica que posteriormente enviaremos a los buscadores.

¿Qué permite incluir el sitemap de una web? Sencillo, toda la información relevante de indexar para que los buscadores la encuentren, como las fotografías y la fecha de modificación, el contenido, rutas html de páginas, blogs, categorías que queramos indexar, etc.

Como consultores SEO debemos saber que las arañas, el primer fichero que rastrean, es el robots.txt por ello es tan importante prestarle atención, porque a través de él marcaremos la hoja de ruta para nuestra web.

Imaginad una tienda online con miles de páginas, con fichas de producto sin completar. Nuestra redacción de contenido puede tardar en completar toda esa información, por ello, podemos bloquear el rastreo o indexación y activar solo aquellas fichas de producto y categorías completamente trabajadas en factores SEO.

Si le facilitas el trabajo de rastreo de tu web a #Google mejorará tu posicionamiento ❤️ Clic para tuitearDesde digitalDot tenemos dos predilecciones. La primera es generarlo con Yoast SEO o Rank Math PLugin SEO WordPress, no conoces este último plugin, empieza ya a disfrutar de sus grandes ventajas, el plugin de SEO que desbancó a Yoast desde 2019.

Estos dos Plugins para WordPress son de los mejores en cuanto a factores de SEO aparte de poder generar nuestro fichero txt con editor de texto.

Sitemap: https://www.digitaldot.es/sitemap_index.xml

Si estamos en desarrollo o con la redacción de contenidos, o hemos instalado una demo a nuestro cliente, lo primero que querremos es que esos Lorem Ipsum o textos de prueba que no son definitivos, no lleguen a los buscadores.

En alguna ocasión se han montado web de demostración y aunque tenían el acceso limitado por el htaccess hemos visto como Google ha indexado una URL de preproducción por lo que no está de más bloquearlos desde este punto para evitar errores de textos duplicados.

User-agent: * Disallow: /

*Recordad que, si esto os ocurre, desde la herramienta de Webmaster de Google podremos solicitar la desindexación de dominios o de páginas concretas, recientemente lo tuvimos que hacer para una página web y se solucionó en menos de 24 Horas.

Podemos evitar que nos rastreen ciertas zonas como el wp-admin o URLs que queremos proteger que se filtren contenido. Debemos tener en cuenta que es una falsa sensación de seguridad, ya que no rastrear no quiere decir que no se pueda acceder.

Que una URL no se pueda rastrear no quiere decir que no se pueda acceder. #palabradedigitalDot ? Clic para tuitearUn error muy común de los administradores de sistemas o de los gestores es dejar copias en la carpeta raíz de nuestro sitio web, si permitimos el rastreo de cierto tipo de contenidos las arañas podrían localizar y mostrar nuestra base de datos y contraseñas o nuestros clientes suscriptos. Un fallo muy grave de seguridad.

Ejemplo de bloqueos de tipos de archivo y URLs:

Disallow: /wp- Disallow: /wp-content/ Disallow: /trackback/ Disallow: /wp-admin/ Disallow: /feed/ Disallow: /?s= Disallow: /search Disallow: /archives/ Disallow: /index.php Disallow: /*? Disallow: /*.php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: */feed/ Disallow: */trackback/ Disallow: /page/ Disallow: /tag/ Disallow: /category/ # No indexar copias de seguridad Disallow: /*.sql$ Disallow: /*.zip Disallow: /*.7zip Disallow: /*.tgz$ Disallow: /*.gz$ Disallow: /*.tar$ Disallow: /*.svn$

Quieres conseguir un robots.txt adaptado a tu sitio pregunta a nuestros consultores SEO.

Horario de atención al cliente:

L-V 8.00-14.00

L-J 14.00-18.00